Các công cụ cào dữ liệu các trang web (Web Scraping) được phát triển để trích xuất thông tin từ các trang web. Chúng còn được gọi là công cụ thu thập web hoặc công cụ trích xuất dữ liệu web.

Những công cụ này rất hữu ích cho bất kỳ ai đang cố gắng thu thập một số dạng dữ liệu từ Internet. Web Scraping là kỹ thuật nhập dữ liệu mới không yêu cầu nhập lặp đi lặp lại hoặc sao chép thủ công.

Phần mềm này tìm kiếm dữ liệu mới theo cách thủ công hoặc tự động, tìm thêm dữ liệu mới hoặc cập nhật và lưu trữ chúng để bạn dễ dàng truy cập. Ví dụ: một người có thể thu thập thông tin về các sản phẩm và giá của chúng từ Amazon bằng cách sử dụng một công cụ web scraping này.

Tại sao bạn cần công cụ Web Scraping?

Các công cụ Web Scraping có thể được sử dụng cho nhiều mục đích khác nhau.

Thu thập dữ liệu để nghiên cứu thị trường

Các công cụ tìm kiếm trên web có thể giúp bạn bám sát nơi công ty hoặc ngành của bạn đang hướng tới trong sáu tháng tới, đóng vai trò là một công cụ mạnh mẽ để nghiên cứu thị trường.

Các công cụ này có thể lấy dữ liệu từ nhiều nhà cung cấp phân tích dữ liệu và các công ty nghiên cứu thị trường, đồng thời hợp nhất chúng thành một điểm để dễ dàng tham khảo và phân tích.

Trích xuất thông tin liên hệ

Những công cụ này cũng có thể được sử dụng để trích xuất dữ liệu như email và số điện thoại từ các trang web khác nhau, giúp bạn có thể có danh sách các nhà cung cấp, nhà sản xuất và những người khác quan tâm đến doanh nghiệp hoặc công ty của bạn, cùng với địa chỉ liên hệ tương ứng của họ.

Tải xuống các thông tin từ StackOverflow

Bằng cách sử dụng công cụ cào web này, người ta cũng có thể tải xuống các giải pháp để đọc hoặc lưu trữ ngoại tuyến bằng cách thu thập dữ liệu từ nhiều trang web (StackOverflow chẳng hạn).

Tìm kiếm việc làm hoặc ứng viên

Đối với những nhân sự đang tích cực tìm kiếm thêm ứng viên để tham gia nhóm của họ hoặc những người tìm việc đang tìm kiếm một vai trò cụ thể hoặc vị trí công việc, những công cụ này cũng hoạt động hiệu quả để dễ dàng tìm dữ liệu dựa trên các bộ lọc được áp dụng khác nhau và truy xuất dữ liệu hiệu quả mà không tìm kiếm thủ công.

Theo dõi giá từ nhiều thị trường

Nếu bạn tham gia mua sắm trực tuyến và thích chủ động theo dõi giá của các sản phẩm bạn đang tìm kiếm trên nhiều thị trường và cửa hàng trực tuyến, thì bạn chắc chắn cần một công cụ tìm kiếm trên web.

Danh sách các công cụ cào dữ liệu web

Chúng ta hãy xem xét một số công cụ quét web tốt nhất hiện có. Một số trong số chúng là miễn phí, một số trong số chúng có thời gian dùng thử và gói cao cấp. Hãy thử nghiệm trước khi bạn đăng ký bất kỳ dịch vụ nào cho nhu cầu của bạn.

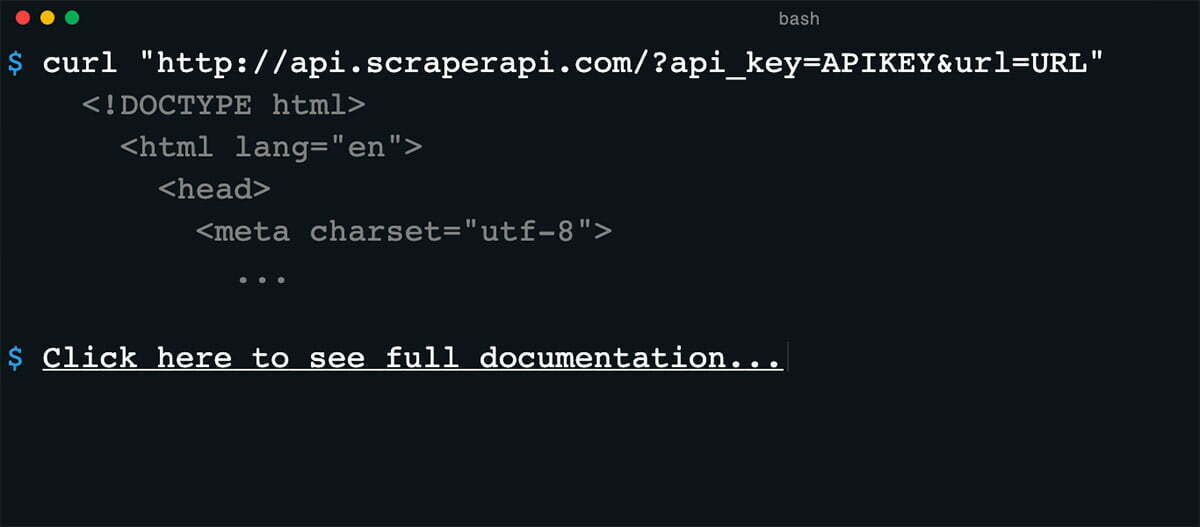

Scraper API

Scraper API được thiết kế để đơn giản hóa việc quét web. Công cụ API proxy này có khả năng quản lý proxy, trình duyệt web và CAPTCHA. Nó hỗ trợ các ngôn ngữ lập trình phổ biến như Bash, Node, Python, Ruby, Java và PHP.

Scraper API có nhiều tính năng; một số trong số những tính năng chính là:

Nó hoàn toàn có thể tùy chỉnh (loại yêu cầu, tiêu đề yêu cầu, trình duyệt không đầu, vị trí địa lý IP).

- Tự đổi IP.

- Hơn 40 triệu IP.

- Tương thích JavaScript Rendering.

- Băng thông không giới hạn với tốc độ lên đến 100Mb/s.

- Hơn 12 vị trí địa lý.

- Dễ dàng tích hợp.

Scraper API cung cấp 4 gói – Sở thích (29 đô la/tháng), Khởi nghiệp (99 đô la/tháng), Doanh nghiệp (249 đô la/tháng) và Doanh nghiệp.

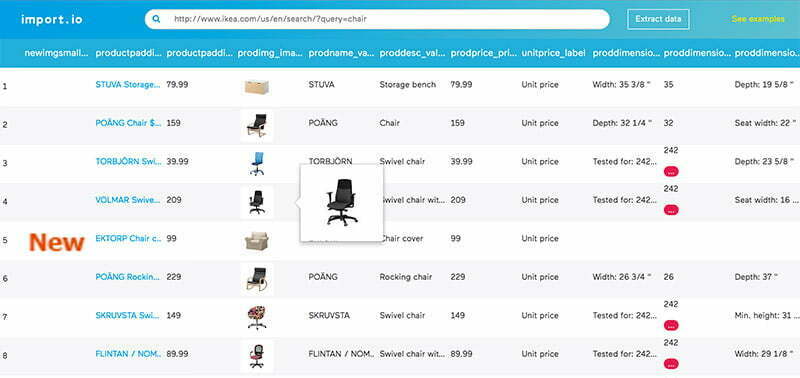

Import.io

Import.io cung cấp một trình thu thập dữ liệu của riêng bạn bằng cách chỉ cần nhập dữ liệu từ một trang web cụ thể và xuất dữ liệu sang CSV.

Bạn có thể dễ dàng tìm kiếm hàng nghìn trang web trong vài phút mà không cần viết một dòng mã nào và xây dựng hơn 1000 API dựa trên yêu cầu của bạn.

Import.io sử dụng nhiều công nghệ khá hay để tìm trích xuất hàng triệu dữ liệu mỗi ngày giúp các doanh nghiệp có thể tận dụng với một khoản phí nhỏ. Cùng với công cụ web, nó cũng cung cấp một ứng dụng miễn phí cho Windows, Mac OS X và Linux để xây dựng trình trích xuất và thu thập dữ liệu, tải xuống dữ liệu và đồng bộ hóa với tài khoản trực tuyến.

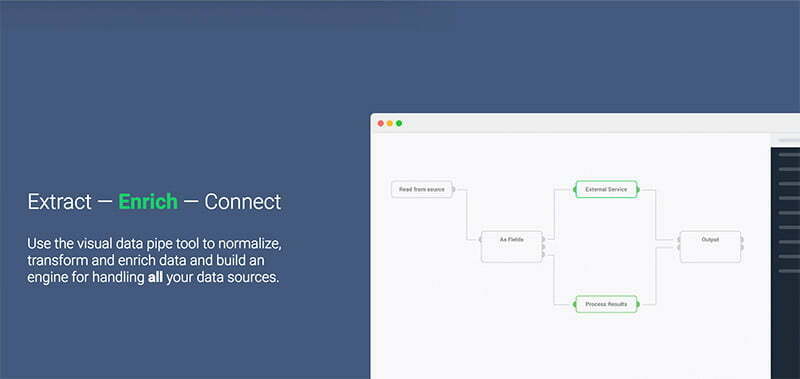

Dexi.io

Dexi.io hỗ trợ thu thập dữ liệu từ bất kỳ trang web nào và không yêu cầu tải xuống giống như Webhose.

Nó cung cấp một trình editor dựa trên trình duyệt để thiết lập trình thu thập thông tin và trích xuất dữ liệu trong thời gian thực. Bạn có thể lưu dữ liệu đã thu thập trên các nền tảng đám mây như Google Drive và Box.net hoặc xuất dưới dạng file CSV hoặc JSON.

Dexi.io cũng hỗ trợ truy cập dữ liệu ẩn danh bằng cách cung cấp một tập hợp các máy chủ proxy để ẩn danh tính của bạn. Dịch vụ này trước đây có tên là CloudScrape. Hiện nay nó hỗ trợ lưu trữ dữ liệu của bạn trên máy chủ trong 2 tuần trước khi xoá. Công cụ hiện tại cung cấp 20 giờ miễn phí và sẽ có giá 29 đô la mỗi tháng.

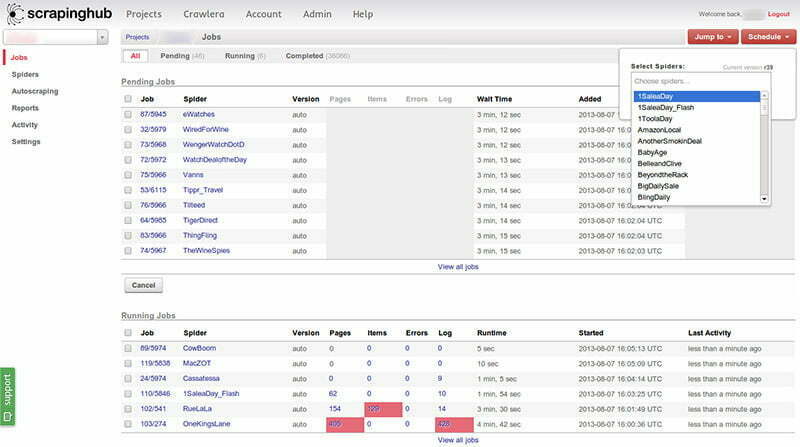

Zyte

Zyte (trước đây có tên là Scrapinghub) là một công cụ trích xuất dữ liệu dựa trên đám mây giúp hàng nghìn nhà phát triển tìm nạp dữ liệu có giá trị.

Zyte sử dụng Crawlera, một công cụ xoay vòng proxy thông minh hỗ trợ bỏ qua các biện pháp chống lại bot để thu thập dữ liệu các trang web khổng lồ hoặc được bảo vệ bởi bot một cách dễ dàng.

Zyte chuyển đổi toàn bộ trang web thành nội dung có tổ chức. Gói miễn phí cơ bản của nó cung cấp cho bạn quyền truy cập vào một lần thu thập thông tin đồng thời và gói cao cấp với giá 25 đô la mỗi tháng cung cấp quyền truy cập vào tối đa bốn lần thu thập thông tin song song.

ParseHub

ParseHub được xây dựng để thu thập dữ liệu một và nhiều trang web với hỗ trợ JavaScript, AJAX, session, cookie và redirect. Ứng dụng này sử dụng công nghệ máy học (machine learning) để nhận dạng các tài liệu phức tạp nhất trên web và tạo tệp đầu ra dựa trên định dạng dữ liệu được yêu cầu.

ParseHub, ngoài ứng dụng web còn có công cụ miễn phí dành cho Windows, Mac OS X và Linux, cung cấp gói miễn phí cơ bản bao gồm năm dự án thu thập thông tin. Dịch vụ này cung cấp gói cao cấp với giá 89 đô la mỗi tháng với hỗ trợ cho 20 dự án và 10.000 trang web cho mỗi lần thu thập thông tin.

80legs

80legs là một công cụ thu thập dữ liệu web mạnh mẽ nhưng linh hoạt có thể được định cấu hình theo nhu cầu của bạn.

Tiện ích hỗ trợ tìm nạp lượng dữ liệu khổng lồ cùng với tùy chọn tải xuống dữ liệu đã trích xuất ngay lập tức. Công cụ quét web tuyên bố thu thập dữ liệu hơn 600.000 tên miền.

80legs cho phép bạn tìm kiếm toàn bộ dữ liệu một cách nhanh chóng, cung cấp tính năng thu thập thông tin web hiệu suất cao, hoạt động nhanh chóng và tìm nạp dữ liệu cần thiết chỉ trong vài giây.

Hiện tại dịch vụ cung cấp gói miễn phí cho 10 nghìn URL mỗi lần thu thập thông tin và có thể được nâng cấp lên gói giới thiệu với giá 29 đô la mỗi tháng cho 100 nghìn URL mỗi lần thu thập thông tin.

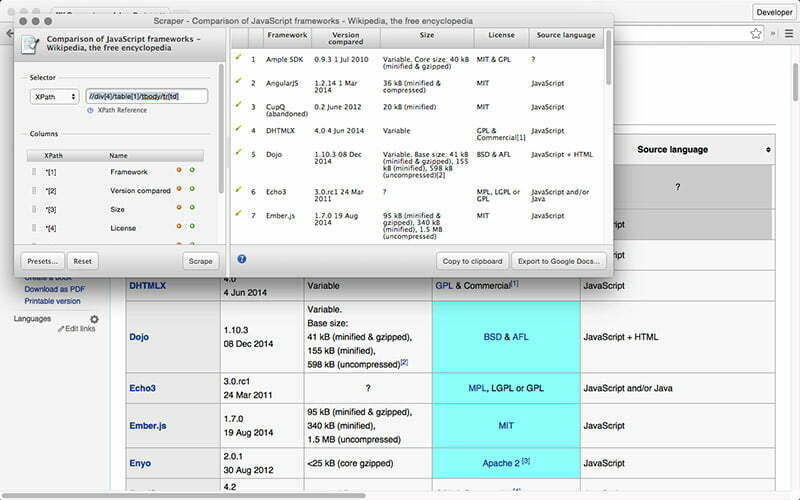

Scraper

Scraper là một tiện ích mở rộng của Chrome với các tính năng trích xuất dữ liệu hạn chế nhưng nó rất hữu ích cho việc nghiên cứu trực tuyến và xuất dữ liệu sang Google Spreadsheets. Công cụ này dành cho người mới bắt đầu cũng như các chuyên gia có thể dễ dàng sao chép dữ liệu vào khay nhớ tạm hoặc lưu trữ vào bảng tính bằng OAuth.

Scraper là một công cụ miễn phí, hoạt động ngay trong trình duyệt của bạn và tự động tạo XPath để xác định URL cần thu thập thông tin. Nó không cung cấp cho bạn sự dễ dàng thu thập thông tin tự động hoặc bot như Import, Webhose và những thứ khác, nhưng nó cũng mang lại lợi ích cho người mới và nó miễn phí.

Sitechecker

Sitechecker cung cấp trình cào dữ liệu trang web dựa trên đám mây trong thời gian thực và cung cấp phân tích kỹ thuật SEO. Trung bình, công cụ thu thập thông tin lên đến 300 trang trong 2 phút, quét tất cả các liên kết bên trong và bên ngoài, đồng thời cung cấp cho bạn một báo cáo toàn diện ngay trên trang tổng quan của bạn.

Bạn có thể tùy chỉnh các quy tắc và bộ lọc của trình thu thập thông tin với các cài đặt linh hoạt theo yêu cầu của mình và nhận được điểm số trang web đáng tin cậy cho bạn biết về tình trạng trang web của bạn.

Ngoài ra, nó sẽ thông báo cho bạn qua email về tất cả các vấn đề trên trang web của bạn và bạn cũng có thể cộng tác với các thành viên trong nhóm và nhà thầu của mình bằng cách gửi một liên kết có thể chia sẻ đến dự án.

ScrapingBot

ScrapingBot là một API quét web tuyệt vời dành cho các nhà phát triển web, những người cần thu thập dữ liệu từ một URL. Nó hoạt động đặc biệt tốt trên các trang sản phẩm nơi nó có thể thu thập tất cả những gì bạn cần (hình ảnh, tiêu đề sản phẩm, giá sản phẩm, mô tả sản phẩm, kho hàng, chi phí giao hàng, v.v.). Nó là một công cụ tuyệt vời cho những người cần thu thập dữ liệu thương mại hoặc đơn giản là tổng hợp dữ liệu sản phẩm và giữ cho nó chính xác.

ScrapingBot cũng cung cấp nhiều API chuyên biệt khác nhau dành cho kết quả tìm kiếm trên Google hay thu thập dữ liệu trên mạng xã hội (LinkedIn, TikTok, Instagram, Facebook, Twitter).

Nếu có tool nào khác bạn muốn chia sẻ nữa thì hãy để lại bình luận nhé!