Pruna AI, một startup tại châu Âu, đã chính thức mở nguồn mã cho khung tối ưu hóa của mình vào thứ Năm. Khung này kết hợp nhiều phương pháp như lưu trữ, chặt tỉa, định lượng và chưng cất để nâng cao hiệu quả cho các mô hình trí tuệ nhân tạo. Theo John Rachwan, đồng sáng lập và CTO của Pruna AI, công ty đã phát triển một cách tiêu chuẩn hóa cho việc lưu và tải các mô hình đã được nén, đồng thời đánh giá chất lượng sau khi nén.

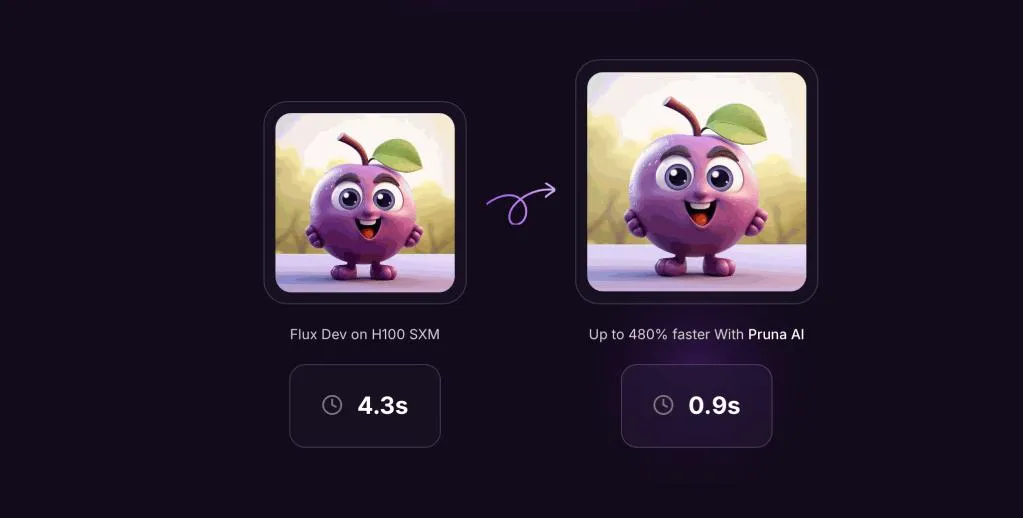

Khung của Pruna AI có khả năng xác định xem có mất mát chất lượng đáng kể nào sau khi nén mô hình hay không, cùng với việc đánh giá những lợi ích về hiệu suất mà người dùng nhận được. Rachwan đã so sánh Pruna AI với Hugging Face, nhấn mạnh rằng họ đang tạo ra một sự đồng nhất trong việc áp dụng các phương pháp hiệu quả cho các mô hình AI.

Nhiều phòng thí nghiệm AI lớn đã áp dụng các phương pháp nén khác nhau. Chẳng hạn, OpenAI đã sử dụng phương pháp chưng cất để tạo ra các phiên bản nhanh hơn của các mô hình chủ lực của họ. Đặc biệt, cách thức này đã giúp OpenAI phát triển GPT-4 Turbo, một phiên bản nhanh hơn của GPT-4. Tương tự, mô hình tạo hình ảnh Flux.1-schnell là một phiên bản chưng cất của mô hình Flux.1 từ Black Forest Labs.

Chưng cất là một kỹ thuật rất quan trọng, cho phép trích xuất kiến thức từ một mô hình lớn bằng cách sử dụng mô hình “giáo viên-học sinh”. Điều này giúp tạo ra một mô hình sinh viên có khả năng tái hiện hành vi của giáo viên mà không phải làm lại từ đầu.

Rachwan nhấn mạnh rằng trong khi các công ty lớn thường phát triển các công cụ nén nội bộ, yếu tố mà Pruna AI mang lại chính là sự kết hợp tất cả các phương pháp vào một công cụ dễ sử dụng. Ngoài ra, công ty này chưa ngừng lại ở việc hỗ trợ cho các mô hình lớn mà còn mở rộng sang cả các mô hình tạo hình ảnh, video, và nhận dạng giọng nói.

Các khách hàng hiện tại của Pruna AI bao gồm Scenario và PhotoRoom, và ngoài phiên bản mã nguồn mở, Pruna AI còn cung cấp một phiên bản doanh nghiệp với các tính năng tối ưu hóa nâng cao nhất, bao gồm cả một tác nhân tối ưu hóa đang được phát triển. Tác nhân này cho phép người dùng dễ dàng yêu cầu điều chỉnh tốc độ mà không làm giảm độ chính xác quá 2%.

Phân khúc mà Pruna AI nhắm đến đang mở rộng, với mục tiêu tạo ra một tác nhân nén cho phép người dùng tối ưu hóa mô hình của họ một cách tự động và hiệu quả. Pruna AI hiện tính phí theo giờ cho phiên bản chuyên nghiệp của mình, tương tự như cách người dùng thuê GPU trên các dịch vụ đám mây như AWS.

Với một mô hình được tối ưu hóa tốt, Pruna AI khẳng định rằng người dùng sẽ tiết kiệm đáng kể chi phí cho các yêu cầu xử lý, bằng chứng là một mô hình Llama đã được thu nhỏ đến tám lần mà không gây tổn thất quá nhiều về chất lượng. Pruna AI đang tìm cách để các khách hàng của mình xem khung nén của họ như một khoản đầu tư tự thu hồi.

Gần đây, Pruna AI đã huy động được 6,5 triệu đô la từ vòng đầu tư giống, với sự tham gia của các nhà đầu tư như EQT Ventures, Daphni, Motier Ventures và Kima Ventures. Với những đổi mới này, Pruna AI đang đứng ở vị trí trung tâm trong cuộc đua phát triển các giải pháp tối ưu hóa mô hình AI,

Công ty này được kỳ vọng sẽ thay đổi cách mà các tổ chức sử dụng mô hình AI trong tương lai.