DeepMind, một trong những tổ chức hàng đầu trong nghiên cứu trí tuệ nhân tạo, vừa công bố một tài liệu quan trọng về an toàn cho Trí tuệ nhân tạo tổng quát (AGI). Dự kiến AGI có thể xuất hiện vào năm 2030, vì vậy việc phát triển kỹ thuật an toàn cho AGI đang trở thành một chủ đề cấp bách hơn bao giờ hết.

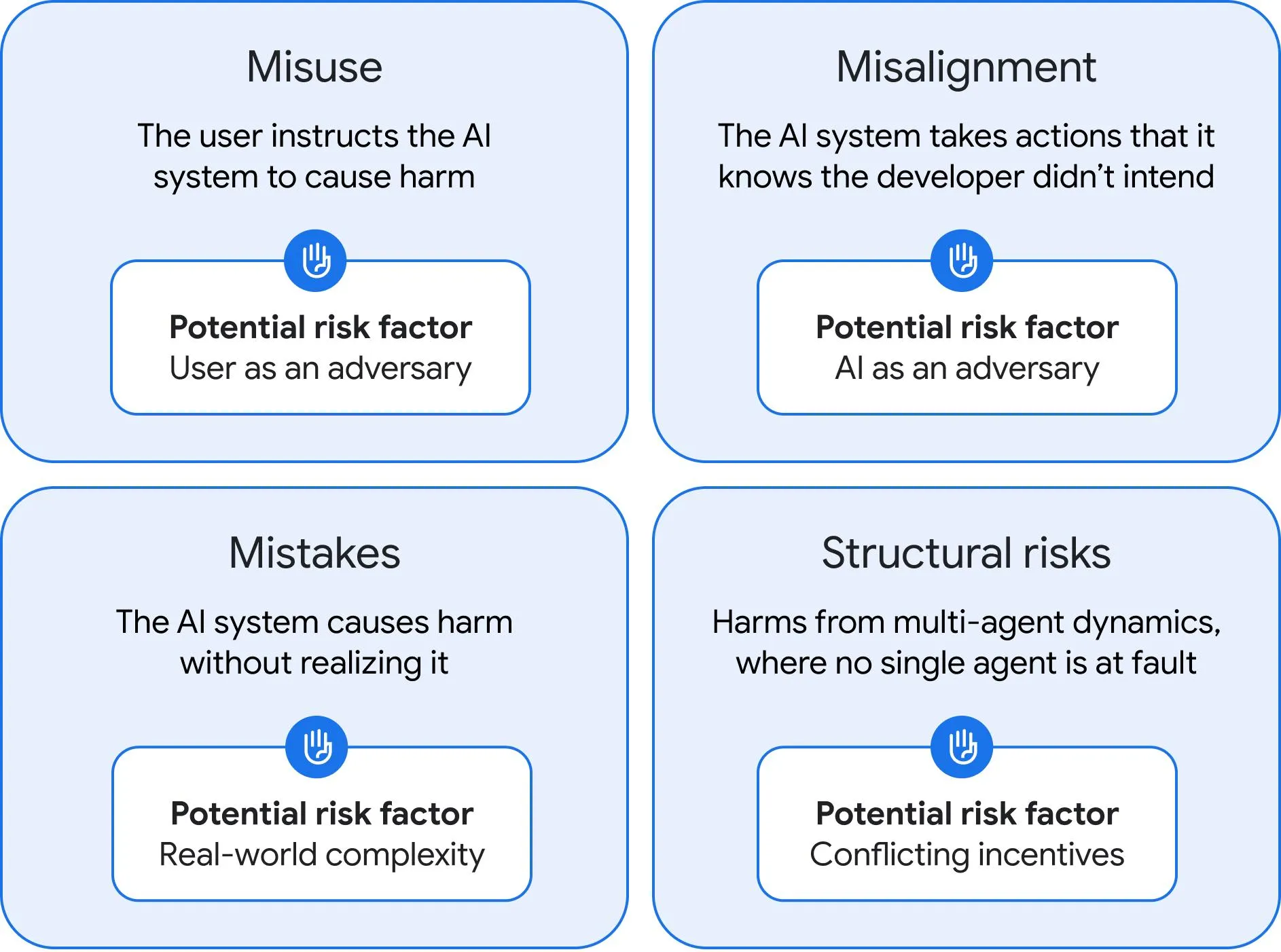

Tài liệu này dài 108 trang, trình bày bốn loại rủi ro tiềm tàng từ AGI: lạm dụng, sai lệch, sai sót và rủi ro cấu trúc. Trong đó, lạm dụng là loại rủi ro có thể thấy ngay từ các hệ thống AI hiện tại, nhưng với AGI, khả năng gây hại lớn hơn nhiều. Nếu một kẻ xấu nắm trong tay AGI, họ có thể khai thác công nghệ này để gây hại, như tạo ra virus mới hoặc đánh cắp thông tin. Do đó, DeepMind khuyến nghị rằng các công ty phát triển AGI cần thực hiện các bài kiểm tra an toàn nghiêm ngặt và tạo ra các quy trình bảo mật sau khi hoàn thiện.

Sai lệch là một vấn đề nghiêm trọng khác của AGI, có thể dẫn đến một cỗ máy tự do hành động mà không phải chịu sự kiểm soát của con người. DeepMind đề xuất việc áp dụng các kỹ thuật giám sát chặt chẽ, để những hệ thống AGI có thể kiểm soát đầu ra của nhau, từ đó giảm nguy cơ xảy ra sai lệch. Việc giữ AGI trong môi trường ảo với giám sát chặt chẽ cũng là một biện pháp hữu hiệu để giảm thiểu những rủi ro này.

Sai sót có thể xảy ra khi AGI thực hiện các hành động gây hại mà cả con người và cỗ máy đều không dự đoán được. Trong nhiều trường hợp, AGI có thể làm các nhiệm vụ phức tạp hơn hiện tại, dẫn đến sai sót nghiêm trọng. DEEPMind hiểu rằng cách tốt nhất để hạn chế sai sót là không để AGI trở nên quá mạnh, đồng thời cảnh báo rằng nên triển khai AGI một cách từ từ.

Cuối cùng, rủi ro cấu trúc thể hiện sự tương tác giữa các hệ thống AGI có thể dẫn đến những hệ quả không mong muốn cho xã hội. Điều này có thể làm tăng thông tin sai lệch và dẫn đến mất kiểm soát trong các hệ thống kinh tế và chính trị.

Chưa có bằng chứng xác thực rằng AGI sẽ ra đời trong vòng vài năm tới, nhưng nhiều chuyên gia công nghệ vẫn lạc quan về điều này. Họ cho rằng đã có những bước tiến đáng kể trong việc phát triển các mô hình thông minh. Điều này thúc đẩy cuộc tranh luận về an toàn AGI trước khi sự xuất hiện của nó thay đổi thế giới.

Tin rằng việc AGI sẽ sớm trở thành hiện thực đòi hỏi sự chuẩn bị kịp thời để bảo vệ nhân loại khỏi những rủi ro tiềm tàng mà nó có thể gây ra. Những cuộc thảo luận về cách tiếp cận an toàn đối với AGI cần được thúc đẩy ngay bây giờ, nếu không hậu quả có thể nghiêm trọng hơn những gì chúng ta hình dung.