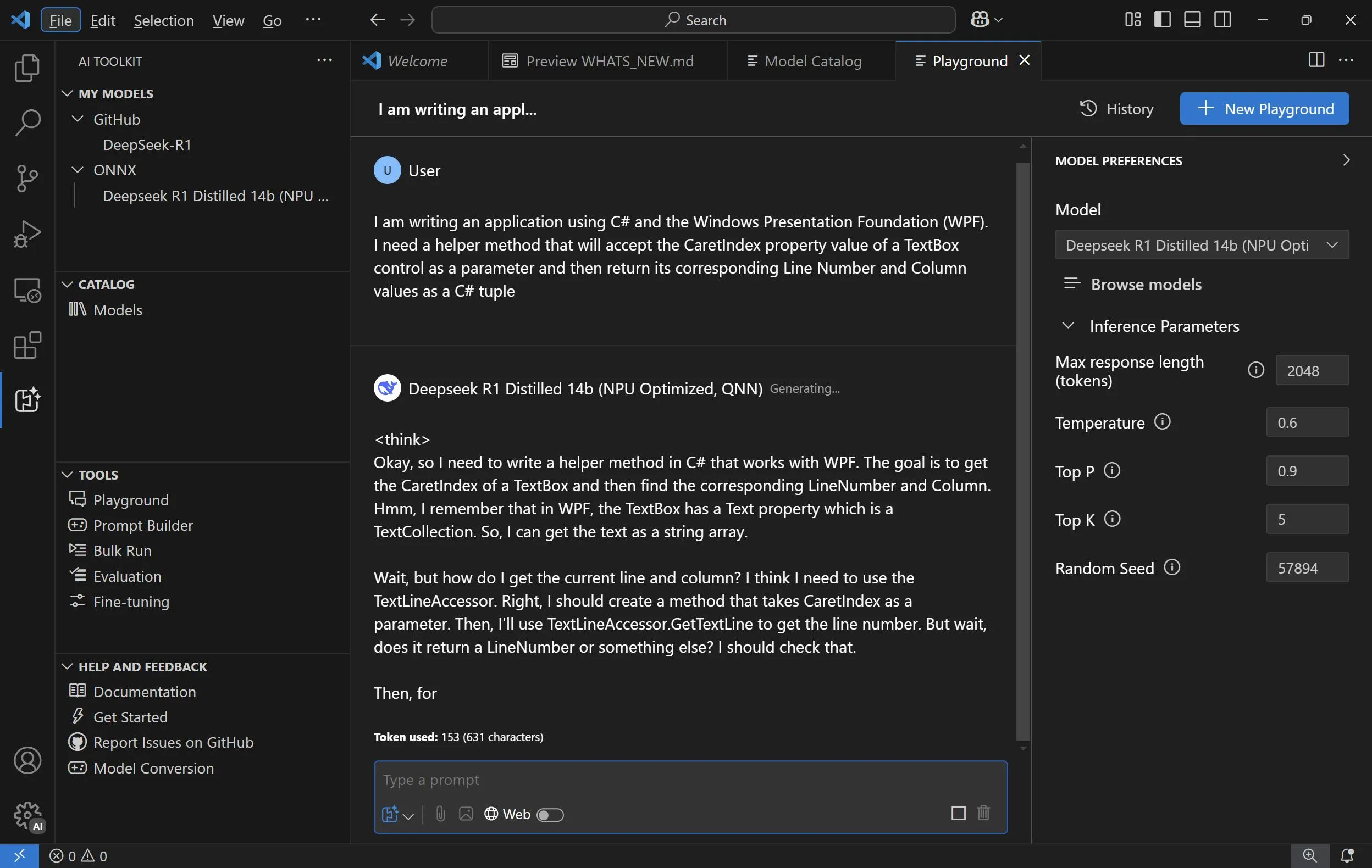

Microsoft vừa công bố hai phiên bản mới của các mô hình AI DeepSeek tối ưu hóa cho máy tính Copilot+, cung cấp sức mạnh tính toán địa phương hiệu quả hơn. Theo Microsoft, tương lai của AI đang diễn ra ngay bây giờ, trải dài từ đám mây đến các thiết bị ngoại vi. Họ đang nỗ lực tạo nên một nền tảng Windows hoàn hảo cho đổi mới AI, nơi mà trí thông minh không chỉ nằm ở đám mây mà còn được tích hợp một cách liền mạch vào hệ thống và phần cứng. Bảng mô hình AI DeepSeek R1 ra mắt vào tháng 1 đã gây sóng gió khi mô hình AI mới của Trung Quốc nhanh chóng thu hút sự chú ý. Microsoft không những không né tránh mà còn nhanh chóng chấp nhận DeepSeek. Chỉ sau vài ngày, họ đã phát hành mô hình lý luận R1 cho các lập trình viên thông qua Azure Foundry và GitHub. Tiếp theo đó, các phiên bản nhỏ, tinh chế của mô hình cũng được cung cấp để sử dụng tại chỗ trên các máy tính Copilot+. Vào cuối tháng 1, Microsoft đã phát hành các phiên bản tối ưu hóa NPU của các mô hình DeepSeek R1 cho máy tính Copilot+ chạy Snapdragon X và một vài ngày sau đó, họ đã cung cấp các phiên bản còn mới hơn, được tối ưu hóa hơn với khung ONNX mở để có hiệu suất và độ tin cậy tốt hơn. Việc theo dõi các phiên bản này không hề đơn giản. Mô hình DeepSeek-R1-Distill-Qwen-1.5B đầu tiên cung cấp là mô hình địa phương tinh chế. “B” trong tên mô hình cho biết số lượng các tham số hay biến trọng số mà mô hình đã được đào tạo, thường mô hình có nhiều tham số hơn cung cấp độ tin cậy cao hơn. Tuần này, Microsoft đã “tiến thêm bước nữa” khi phát hành hai phiên bản mới của các mô hình trên, DeepSeek-R1-Distill-Qwen-7B và DeepSeek-R1-Distill-Qwen-14B. Họ cho biết việc chạy các mô hình này tại chỗ trên một NPU là một cột mốc quan trọng trong việc dân chủ hóa và tăng khả năng tiếp cận AI, cho phép các nhà nghiên cứu, lập trình viên và người đam mê sử dụng sức mạnh và chức năng lớn của các mô hình học máy quy mô lớn ngay từ máy tính Copilot+ của họ. Những mô hình mới này cũng giống như phiên bản 1.5B đầu tiên, là các mô hình lý luận có khả năng thể hiện cách chúng đạt được câu trả lời, nâng cao chất lượng phản hồi không chỉ theo nghĩa đen mà còn theo cách người dùng cảm nhận. Để bắt đầu sử dụng những mô hình này, người dùng cần có một chiếc máy tính Copilot+ chạy Snapdragon X, có hỗ trợ cho các dòng chip AMD Zen 5 và Intel Core Ultra sắp tới, cũng như cần có Visual Studio Code và tiện ích mở rộng AI Toolkit. Khi đã sẵn sàng, người dùng có thể tải xuống một hoặc nhiều mô hình qua AI Toolkit và tương tác với chúng thông qua giao diện chat tại Playground. Dù hoạt động tại chỗ có thể chậm hơn so với đám mây, nhưng người dùng sẽ mãn nhãn khi chứng kiến AI “suy nghĩ” và sản xuất câu trả lời. Với mô hình 14B tôi đang sử dụng, AIê có vẻ như một chatbot, nhưng quá trình tính toán lại chậm hơn. Các lập trình viên có thể kích hoạt chế độ “Web” để bao gồm kết quả tìm kiếm web trong câu trả lời nếu muốn có trải nghiệm đa dạng hơn. Copilot+ kết hợp khả năng tính toán hiệu suất với sức mạnh tính toán gần như không giới hạn mà Microsoft cung cấp thông qua dịch vụ Azure. Microsoft ghi nhận rằng việc lý luận có thể kéo dài giữa đám mây và ngoại vi, hoạt động liên tục trên PC và kích hoạt các mô hình lớn hơn trong đám mây khi cần thiết, mở ra một mô hình tính toán liên tục tạo ra giá trị cho khách hàng. Tương lai của tính toán AI đang trở nên sáng sủa hơn bao giờ hết. Chúng ta mong chờ những đổi mới từ cộng đồng lập trình viên trong việc tận dụng những khả năng phong phú này.